विषयसूची:

- मॉडल की व्याख्या क्या है?

- गहरी शिक्षा में व्याख्यात्मकता क्या है?

- एआई सिस्टम के संदर्भ में व्याख्यात्मकता का क्या अर्थ है?

- व्याख्यात्मक समस्या क्या है?

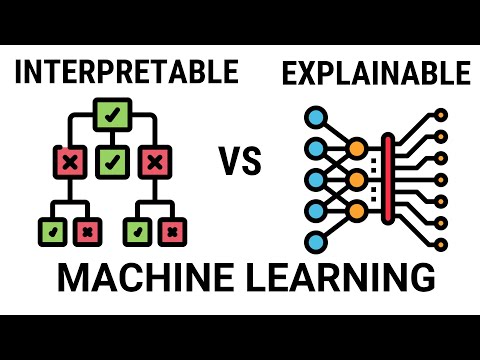

वीडियो: पारदर्शिता और व्याख्यात्मकता में अंतर कैसे होता है?

2024 लेखक: Fiona Howard | [email protected]. अंतिम बार संशोधित: 2024-01-10 06:37

पारदर्शिता आसानी से व्याख्या करने योग्य मॉडल का उपयोग करके इस समस्या को हल करती है, जिनमें से कुछ पर हम अगले भाग में बात करेंगे। व्याख्यात्मकता इस समस्या को "ब्लैक बॉक्स को खोलकर" या मशीन लर्निंग मॉडल से अक्सर सांख्यिकीय विधियों का उपयोग करके अंतर्दृष्टि प्राप्त करने का प्रयास करके हल करती है।

मॉडल की व्याख्या क्या है?

मॉडल की व्याख्याशीलता एमएल मॉडल द्वारा प्रदान किए गए परिणामों के विश्लेषण और समझने की एक व्यापक अवधारणा है। यह अक्सर "ब्लैक-बॉक्स" मॉडल के संदर्भ में उपयोग किया जाता है, जिसके लिए यह प्रदर्शित करना मुश्किल है कि मॉडल एक विशिष्ट निर्णय पर कैसे पहुंचा।

गहरी शिक्षा में व्याख्यात्मकता क्या है?

व्याख्यात्मकता (जिसे "व्याख्यात्मकता" भी कहा जाता है) एक अवधारणा है कि एक मशीन लर्निंग मॉडल और इसके आउटपुट को इस तरह से समझाया जा सकता है कि एक स्वीकार्य स्तर पर एक इंसान के लिए "समझ में आता है" … अन्य, जैसे डीप लर्निंग सिस्टम, अधिक प्रदर्शनकारी होने के बावजूद, समझाने में बहुत कठिन होते हैं।

एआई सिस्टम के संदर्भ में व्याख्यात्मकता का क्या अर्थ है?

एंड्रयू माटुरो, डेटा विश्लेषक, एसपीआर। “सरल शब्दों में समझाने योग्य AI का अर्थ है AI जो अपने संचालन में पारदर्शी है ताकि मानव उपयोगकर्ता निर्णयों को समझ सकें और उन पर भरोसा कर सकें संगठनों को प्रश्न पूछना चाहिए – क्या आप बता सकते हैं कि आपके AI ने इसे कैसे उत्पन्न किया विशिष्ट अंतर्दृष्टि या निर्णय? -

व्याख्यात्मक समस्या क्या है?

लोगों में एक स्पष्ट ब्लैक-बॉक्स निर्णयों से घृणा है जो उन्हें आर्थिक रूप से, स्वास्थ्य की दृष्टि से और दर्जनों अन्य तरीकों से प्रभावित करते हैं, जबकि एक ही समय में कुछ विभिन्न प्रकार के निर्णयों से बेखबर होते हैं।. … जब एआई ये निर्णय लेता है, तो स्पष्टीकरण की मांग सुनी जा सकती है।

सिफारिश की:

मनुष्यों में समय के अंतर में अंतर?

मनुष्यों या जानवरों के संबंध में इंटरऑरल टाइम डिफरेंस (या आईटीडी) है दो कानों के बीच ध्वनि के आने के समय में अंतर। यह ध्वनियों के स्थानीकरण में महत्वपूर्ण है, क्योंकि यह सिर से ध्वनि स्रोत की दिशा या कोण का संकेत देता है। आप इंटरऑरल टाइम डिफरेंस का उपयोग कब करेंगे?

व्याख्यात्मकता का क्या अर्थ है?

व्याख्यात्मक की परिभाषाएँ। विशेषण। समझने में सक्षम। समानार्थी शब्द: व्याख्या करने योग्य व्याख्या करने योग्य। खोजे जाने या हिसाब देने में सक्षम। गहरी शिक्षा में व्याख्यात्मकता क्या है? एक और है: व्याख्यात्मकता वह डिग्री है जिस तक मानव लगातार मॉडल के परिणाम की भविष्यवाणी कर सकता है 4 किसी की व्याख्यात्मकता जितनी अधिक होगी मशीन लर्निंग मॉडल, किसी के लिए यह समझना जितना आसान है कि कुछ निर्णय या भविष्यवाणियां क्यों की गई हैं। क्या व्याख्या योग्य एक वास्तविक शब्द ह

क्या जेपीईजी में पारदर्शिता है?

जेपीईजी प्रारूप पारदर्शिता का समर्थन नहीं करता… हमारी अल्फा चैनल छवि में एक सफेद पिक्सेल पूरी तरह से अपारदर्शी इंगित करता है, जबकि एक काला पिक्सेल पूरी तरह से पारदर्शी इंगित करता है। बीच में रंग पारदर्शिता के संबंधित स्तर को इंगित करते हैं। रंग जानकारी और पारदर्शिता को मिलाकर, हम एक समग्र बिटमैप बना सकते हैं। क्या पीएनजी या जेपीईजी में पारदर्शिता है?

क्या बाईबल में पारदर्शिता है?

अनुच्छेदों ने घोषणा की कि "प्रभु भोज के प्रभु भोज में केवल ट्रांसबस्टैंटियेशन (या रोटी और शराब के पदार्थ का परिवर्तन) एक वैध रूप से नियुक्त पुजारी वैध रूप से कर सकता है यूचरिस्ट का अभिषेक करें जैसा कि कैनन कानून में कहा गया है, "पवित्र भोज का साधारण मंत्री एक बिशप, प्रेस्बिटर या डेकन है।"

प्रतिकृति के दौरान लीडिंग और लैगिंग स्ट्रैंड में अंतर होता है?

प्रमुख स्ट्रैंड को उसी दिशा में संश्लेषित किया जाता है जैसे प्रतिकृति कांटा प्रतिकृति कांटा की गति प्रतिकृति कांटा एक संरचना है जो डीएनए प्रतिकृति के दौरान लंबे पेचदार डीएनए के भीतर बनती है यह हेलिकेस द्वारा बनाया गया है, जो हेलिक्स में दो डीएनए स्ट्रैंड को एक साथ रखने वाले हाइड्रोजन बॉन्ड को तोड़ता है। परिणामी संरचना में दो शाखाएं "